Wat is Apache Spark?

Data omzetten in groei en inzicht

Meten is weten, maar de enorme hoeveelheid data die organisaties dagelijks verzamelen is voor mensen nauwelijks te overzien. Apache Spark maakt dit wél mogelijk. Dit krachtige framework verwerkt grote hoeveelheden gegevens razendsnel en zet ongrijpbare data om in bruikbare inzichten en slimme voorspellingen. Zo wordt data niet langer een last, maar een groeimiddel dat uw bedrijf vooruithelpt.

Achtergrond

Wat is Apache Spark?

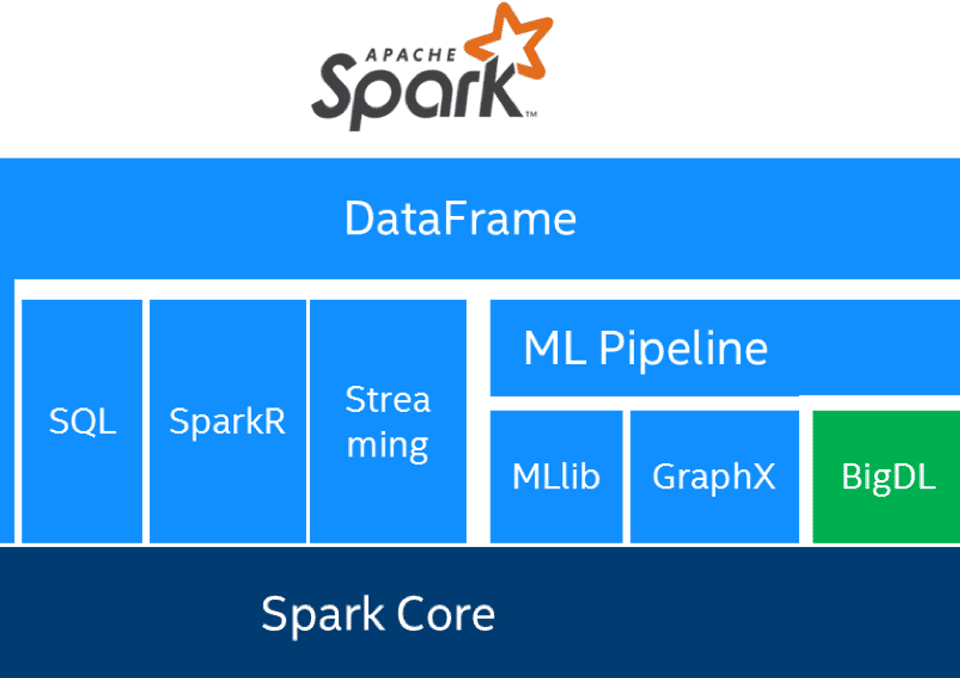

Apache Spark is veel meer dan alleen een systeem voor dataopslag: het is een krachtig framework voor het verwerken en analyseren van enorme hoeveelheden gegevens. U kunt het zien als een online netwerk van servers dat speciaal is ontworpen om data razendsnel te verwerken. Daarmee vormt het de volgende generatie dataplatform, ideaal voor toepassingen als het Internet of Things (IoT), waarin talloze apparaten continu met elkaar communiceren. Ook bij machine learning is snelheid essentieel, en precies daar blinkt Apache Spark in uit: live en grootschalige dataverwerking waarmee software sneller leert, patronen herkent en betere voorspellingen doet.

Het lukt met Apache Spark

Groeifactor voor uw organisatie

Zelflerende computers en verbonden apparaten leveren continu nieuwe inzichten op. Met Apache Spark worden die gegevens niet alleen opgeslagen, maar ook omgezet in voorspellingen voor de toekomst. Zo krijgt u grip op uw data en kunt u betere bedrijfskeuzes maken, processen optimaliseren en nieuwe groeikansen benutten.

APPelit heeft met Spark voor diverse organisaties maatwerkoplossingen ontwikkeld op het gebied van kunstmatige intelligentie en data-analyse. Daarmee vertalen we complexe data naar concrete resultaten. Wilt u weten wat dit voor uw organisatie kan betekenen? Laat u hieronder inspireren of vraag direct vrijblijvend advies aan.

Waar werkt Apache Spark goed voor?

Vijf populaire toepassingen

Apache Spark staat bekend om zijn veelzijdigheid. Het systeem is breed inzetbaar en helpt organisaties om data sneller te benutten en waardevolle inzichten te genereren. De vijf populairste toepassingen zijn:

1. Big data business intelligence

Bedrijven gebruiken Spark om enorme datasets te analyseren en te vertalen naar dashboards en rapportages. Zo ontstaan realtime inzichten die direct bruikbaar zijn in de besluitvorming.

2. Dataopslag en verwerking (data warehouse)

Spark fungeert als fundament voor moderne data warehouses. Het combineert opslag en razendsnelle verwerking, waardoor u niet alleen data verzamelt maar deze ook direct kunt inzetten.

3. Gepersonaliseerde aanbevelingen voor webshops

Dankzij in-memory computing kan Spark razendsnel patronen herkennen in koopgedrag. Zo worden aanbevelingsprogramma’s ontwikkeld die klanten precies laten zien wat voor hen relevant is.

4. Verbeteren van gebruikerservaringen

Door live data te analyseren, kan Spark applicaties en platforms direct aanpassen aan de wensen van gebruikers. Dit leidt tot betere interactie, meer tevreden klanten en hogere conversie.

5. Detectie van fraude en softwarebeveiliging

Spark is krachtig in het herkennen van afwijkende patronen, bijvoorbeeld bij financiële transacties of online activiteiten. Daarmee vormt het een waardevolle basis voor fraudedetectie en beveiligingsoplossingen.

Kortom: of het nu gaat om inzicht, efficiëntie of veiligheid, Apache Spark maakt data tastbaar en bruikbaar. Met de juiste implementatie wordt het een sleuteltechnologie voor bedrijven die vooruit willen.

Ook daar werken wij mee

Alternatief voor Apache Spark: Hadoop

Voordat Apache Spark zijn opmars maakte, werd Apache Hadoop veel gebruikt als framework voor dataopslag en analyse. Beide systemen draaien op een netwerk van servers in de cloud en worden wereldwijd toegepast door organisaties die met big data werken. APPelit heeft ervaring met beide technologieën en adviseert u welk platform het best aansluit bij uw situatie.

Voordelen van Apache Spark ten opzichte van Hadoop

-

Snellere analyses: Spark voert live-analyses en complexe berekeningen aanzienlijk sneller uit.

-

In-memory computing: Gegevens worden in het geheugen verwerkt in plaats van op schijf, waardoor data sneller wordt geladen en opgeslagen.

-

Flexibele query’s: Herhaalde opdrachten aan de database verlopen soepel en zonder merkbare vertraging.

-

Gebruiksvriendelijk: Spark is makkelijker te programmeren en ondersteunt meerdere programmeertalen.

-

Integratie met Scala: Voor lokaal opgeslagen data biedt de combinatie Spark en Scala extra bewerkingsmogelijkheden.

-

Geen vooraf structureren: Data hoeft niet eerst gerangschikt te worden, wat tijd en voorbereiding scheelt.

-

Grotere schaalbaarheid: Spark biedt meer ruimte en flexibiliteit in dataopslag en verwerking.

Samenwerking tussen Spark en Hadoop

Het mooie is dat Spark en Hadoop niet als concurrenten gezien hoeven te worden. Integendeel: ze versterken elkaar. Spark kan bovenop Hadoop draaien en maakt data-analyse vanaf Hadoop-schijven wel tien keer sneller. In het eigen geheugen van Spark loopt de verwerking zelfs tot honderd keer sneller. Zo combineert u het beste van beide werelden.

Nieuwe kansen in aantocht

Gegevens van overheden via Apache Spark

Apache Spark is een open systeem, wat betekent dat iedereen ermee kan werken en er toepassingen op kan bouwen. Steeds vaker ontdekt ook de overheid de voordelen hiervan. De verwachting is dat overheidsinstanties in de toekomst steeds meer datasets beschikbaar stellen. Dit zijn doorgaans uiterst betrouwbare en complete gegevens, ideaal om te combineren met uw eigen data. Het resultaat: nog nauwkeurigere analyses en scherpere voorspellingen die direct bijdragen aan betere beslissingen.

Denk aan gegevens van de Kamer van Koophandel, gemeenten, provincies, waterschappen en andere publieke partijen. Deze bronnen bevatten waardevolle informatie over bedrijven, omgevingsfactoren, infrastructuur en regelgeving. APPelit heeft ruime ervaring in het koppelen en benutten van dit soort databronnen binnen Apache Spark. Zo helpen wij organisaties om publieke en interne data samen te brengen en om te zetten in inzichten die groei, innovatie en efficiëntie stimuleren.

Voor wie is Apache Spark?

Technologie voor experts

Apache Spark is een krachtig systeem, maar de techniek erachter vraagt veel specialistische kennis. Het platform is vooral bedoeld om data-engineers en datawetenschappers dichter bij elkaar te brengen, zodat zij samen complexe dataproblemen kunnen oplossen. Wilt u Spark binnen uw organisatie inzetten? Dat is zeker een aanrader, maar doorgaans alleen haalbaar met de juiste experts, omdat het simpelweg te complex is om er zonder ervaring mee te werken.

Bij APPelit werken wij dagelijks met Apache Spark en andere data warehouses. Daarbij gebruiken we uiteenlopende programmeertalen en tools, van Python voor AI-toepassingen tot R, SQL en Java. Dankzij die brede expertise vertalen we ingewikkelde technologie naar praktische oplossingen die organisaties écht vooruithelpen. Heeft u zelf niet de kennis in huis? Dan staan wij klaar om u hierbij te ondersteunen.

Wat is Apache Spark voor uw bedrijf?

Samen kansen ontdekken

Wilt u weten wat big data-analyse met Apache Spark concreet kan betekenen voor uw organisatie? Bij APPelit denken wij graag met u mee. In een persoonlijk gesprek brengen we uw doelen en uitdagingen in kaart en laten we zien hoe data kan worden omgezet in inzichten, voorspellingen en nieuwe kansen. Vul hieronder uw gegevens in en wij nemen snel contact met u op om samen de mogelijkheden te verkennen.

Ervaar het gemak van onze service!

Wilt u dat wij contact opnemen? Vul het formulier hieronder in en we bellen u terug.

U kunt ook meer informatie achterlaten via onze contactpagina of het offerteformulier

Ervaar het gemak van onze service!

Wilt u dat wij contact opnemen? Vul het formulier hieronder in en we bellen u terug.

U kunt ook meer informatie achterlaten via onze contactpagina of het offerteformulier